- Лучшие инструменты для web-скрапинга: 30+ парсеров для сбора данных с любого сайта

- 30+ парсеров для сбора данных с любого сайта

- Лучшие инструменты для web-скрапинга

- Parserok

- Xpath-запросы

- Простая таблица

- Браузерные расширения

- Преимущества использования парсеров

- Выбор оптимального парсера

- Примеры парсеров

- Советы по использованию парсеров

- Видео:

- Импорт (парсинг) нетабличных данных с сайтов в Excel с помощью Power Query

Лучшие инструменты для web-скрапинга: 30+ парсеров для сбора данных с любого сайта

Нужные данные могут быть получены с использованием парсингом специальных программ или скриптов. Парсинг данных позволяет получить информацию с любого сайта, включая популярные, такие как Google, Яндекс, PR-CY и других. С помощью парсеров можно собирать различные данные, такие как заголовки (title), метатеги (meta tags), robot.txt, структуру сайта, изображения, ссылки, h1-h6 теги и многое другое.

Для парсинга данных существует много различных видов парсеров, которые могут быть использованы в разных сферах и целях. Например, Comparser предлагает парсеры с облачными решениями и парсеры с доступными ценами. Есть также парсеры, которые специализируются на парсинге сайтов интернет-магазинов, а также парсеры, которые могут быть использованы в SEO для анализа конкурентов.

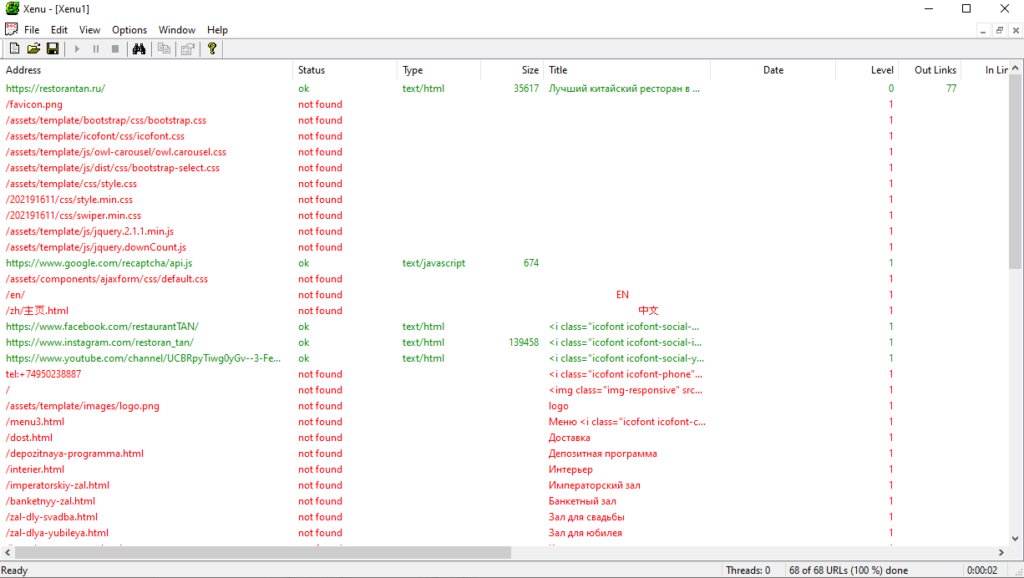

Парсеры для парсинга данных могут предоставлять различный функционал, такой как парсинг списков, сбор и парсинг данных из excel файлов, проверка стандартных тегов, проверка структуры страниц и многое другое. Xenu’s Link Sleuth является десктопным парсером, который позволяет совершать быстрый сбор данных и выполнение множества запросов. Он также предоставляет возможность проверять ссылки и структуру сайта, а также находить ошибки в метатегах.

Парсинг данных с помощью парсеров позволяет получать нужные данные с любого сайта, используя различные технологии и инструменты. Различные парсеры имеют свои особенности и предлагают разные возможности для сбора и обработки данных. Например, парсеры могут парсить данные с сайтов, используя различные теги (h1-h6, title, meta tags), а также изображения, ссылки и другие элементы структуры сайта.

30+ парсеров для сбора данных с любого сайта

- Netpeak Parser — парсер с расширенным функционалом и облачной подпиской. С его помощью можно делать запросы по ссылкам, собирать данные с сайта и многое другое;

- Sleuth — парсер для сбора данных с сайтов и анализа их структуры. Удобно использовать при анализе товаров и страниц сайта;

- Link Parser — парсер для сбора ссылок с сайта. Например, с его помощью можно спарсить title и description страниц;

- Pr-cy parser — парсер для сбора данных с сайта. Удобный интерфейс и минимальный набор нужных сервисов позволяют быстро собрать информацию;

- Parserok — набор парсеров, позволяющий собирать данные с сайтов разного типа. Например, парсер для спарсить данные по товарам на странице;

- Spider — инструмент для мониторинга и сбора данных с веб-сайтов. По заданному xpath-запросу парсеры могут выгружать данные;

- Ranking Parser — парсер для сбора данных о позициях в поисковой выдаче Google. Удобно использовать для мониторинга и анализа рейтингов;

Это только некоторые из множества парсеров, доступных на рынке. Каждый парсер имеет свои уникальные функции и возможности. Выбирайте инструмент с учетом ваших потребностей, ценами и типом сайтов, с которыми вы работаете. Всегда можно взять платный парсер с большим функционалом или воспользоваться бесплатными облачными надстройки к стандартным браузерным расширениям. Ваш выбор!

Лучшие инструменты для web-скрапинга

Существует множество инструментов для web-скрапинга, но мы собрали лучшие из них, чтобы помочь вам в вашей работе:

Parserok

Parserok — один из самых популярных парсеров, который позволяет собирать данные с любого сайта. Он имеет удобный интерфейс и много полезных функций, таких как парсинг заголовков, мета-тегов, описаний и других тегов. Также он позволяет запускать парсеры в облачных сервисах таких как Netpeak и Sleuth.

Xpath-запросы

Если у вас есть нужда в определенных данных или структуре, и вы хотите быстро найти ссылку или нужную информацию, то xpath-запросы — это то, что вам нужно. Вы определите, какую структуру данных вам нужно найти, и инструмент самостоятельно выполнит запрос.

Простая таблица

| Инструмент | Описание |

|---|---|

| Parserok | Мощный парсер для сбора данных с любого сайта, с удобным интерфейсом и функционалом. |

| Xpath-запросы | Специальные запросы для нахождения нужных данных или структуры. |

| Простая таблица | Простой и удобный способ представления данных для анализа. |

Воспользуйтесь этим чек-листом и выберите инструменты, которые подходят вам лучше всего. Не забудьте проверить, какие инструменты позволяют собирать данные быстро и эффективно. Они могут быть полезны в таких сферах как SEO-анализ, анализ конкурентов, анализ совместных покупок и многих других.

Быстро и законно собирайте данные с веб-сайтов с помощью лучших инструментов для web-скрапинга!

Браузерные расширения

Если у вас уже есть опыт работы с другими парсерами, такие как парсеры мета-тегов, xpath-запросы или регулярные выражения, вы можете воспользоваться возможностями браузерных расширений для минимальной настройки и максимального получения нужной информации.

Существует множество браузерных расширений для сбора данных с сайтов, которые позволяют проверить цены на товары, мониторинг сайтов, анализировать содержимое метатегов, визуализировать результаты и многое другое.

Одним из таких инструментов является расширение Netpeak Spider, которое предоставляет широкие возможности для парсинга интернет-магазинов, отслеживания изменений позиций сайтов в поисковой выдаче, а также анализа наполнения страниц и метатегов. Это мощный инструмент, который может быть полезен организаторам сайтов любого типа.

Еще одним хорошим инструментом является расширение Frog, которое позволяет собирать информацию о товарах, находить ошибки в структуре сайта, анализировать данные о конкурентах и многое другое. Этот инструмент особенно полезен для организаторов интернет-магазинов.

Другими популярными расширениями для веб-скрапинга являются Link Klipper, которое позволяет собирать ссылки с веб-страницы, и Scraper, которое позволяет выбрать нужные элементы на странице и собрать данные из них.

Также стоит отметить, что многие парсеры и инструменты для веб-скрапинга совместимы с браузерными расширениями, что позволяет делать парсинг на странице с помощью выбранного инструмента и получать результаты в удобном виде.

В завершение можно сказать, что браузерные расширения предоставляют широкие возможности для решения различных задач веб-скрапинга. Они практически могут заменить десктопные парсеры и другие инструменты, так как сочетают в себе функционал нескольких инструментов.

Преимущества использования парсеров

Прежде всего, парсеры позволяют собирать информацию из любого сайта и использовать ее для различных целей. С их помощью можно собирать данные для анализа seo-позиций сайта в поисковых системах, а также получать информацию о содержимом и структуре других веб-ресурсов.

Функционал парсеров очень широк и предлагает множество возможностей. Например, с помощью парсеров можно анализировать мета-теги и содержимое тегов элементов веб-страницы, таких как title и description. Также парсеры позволяют собирать данные о ссылках, изображениях и других элементах сайта, а также извлекать нужные значения из регулярных выражений.

Среди популярных парсеров можно выделить такие инструменты, как A-Parser, Xenu’s Link Sleuth, ParserOk и многие другие. Эти программы предлагают различные функции и возможности для сбора данных с сайтов.

Еще одним преимуществом парсеров является их доступность. Многие парсеры предлагают возможность запускать сбор данных с веб-страниц в облаке, что позволяет обрабатывать большие объемы информации без необходимости установки программы на десктопные устройства. Кроме того, некоторые парсеры имеют надстройки для популярных сервисов, таких как Google Sheets и Excel, что упрощает работу с полученными данными.

Если вы интернет-маркетолог или владелец интернет-магазина, то парсеры также могут быть полезны для вас. С их помощью вы сможете быстро проверять ссылки ваших товаров на наличие ошибок, анализировать контент конкурентов и проводить другие задачи, связанные с анализом контента сайтов.

Воспользовавшись парсерами, вы сможете найти многое, что будет полезно для вашего бизнеса или работы. Используйте парсеры для сбора данных с любого сайта, применяйте их в различных сферах деятельности и определите свои собственные нужды и задачи, где возможностей парсеров будет очень много.

Таким образом, использование парсеров – это удобный и эффективный способ сбора данных с веб-страниц, который может существенно упростить вашу работу и повысить производительность.

Выбор оптимального парсера

При выборе парсера для сбора данных с веб-сайта вам, возможно, потребуется решить несколько вопросов:

1. Какой тип парсера вам нужен?

На рынке существуют разные виды парсеров, и вам необходимо определиться с тем, какой вам больше подходит. Некоторые парсеры работают на десктопе, а другие доступны в облачной программе. Возможно, вам потребуется парсер, который способен собирать данные с любого сайта, включая интернет-магазины.

2. Какие функциональные возможности вы ищете?

Если вам требуется анализировать структуру веб-сайта или его содержимое, вы можете выбрать парсер с расширенными возможностями. Некоторые парсеры могут собирать заголовки, описания, ключевые значения, изображения и другие данные, а также анализировать теги H1-H6 и настройки robotstxt.

3. Бесплатные или платные парсеры?

На рынке существуют как бесплатные, так и платные парсеры. Бесплатные парсеры обычно имеют ограниченные возможности и могут быть полезны для небольших задач. В то время как платные парсеры удовлетворят ваши потребности в более сложном парсинге и анализе данных с сайтов.

4. Необходимость запуска парсера на десктопе или в облаке?

Если вам нужно быстро и легко спарсить данные с веб-сайта, вы можете выбрать десктопный парсер для Windows. Если же вам требуется более сложный анализ данных или парсер для многих сайтов, то стоит обратить внимание на облачные парсеры, которые доступны через веб-интерфейс.

5. Возможности анализа ошибок и результатов парсинга

Хороший парсер должен предоставлять возможности анализа ошибок и результатов парсинга. Вы должны иметь возможность просмотреть ошибки, возникшие в процессе парсинга, а также просмотреть полученные данные в удобном формате.

Если вы учитываете все эти факторы при выборе парсера, то сможете найти оптимальное решение для вашего анализа данных с веб-сайтов и собирать необходимые данные без лишних усилий.

Примеры парсеров

При помощи парсеров вы можете извлекать нужные данные со страницы любого сайта. Благодаря множеству доступных парсеров вы сможете анализировать контент и данные по различным сферам и запросам.

Одним из популярных парсеров является XPath-запрос, который позволяет анализировать структуру страницы и выбирать нужные значения. С его помощью вы можете быстро извлечь нужные данные из любого сайта.

Еще один пример парсера — Sleuth. Он предоставляет множество функций для парсинга, и его использование практически неотличимо от его конкурентов. Sleuth позволяет собирать данные с сайтов, выгружать их в различных форматах и анализировать результаты.

Для мониторинга позиций и анализа данных организаторов можно использовать парсер Frog. Он предоставляет широкий функционал для парсинга мета-тегов, описания сайта, изображений и других данных.

Если вам требуется парсить данные с большого числа сайтов, то можете воспользоваться сервисом PR-CY, который предоставляет возможность парсинга данных с любого сайта с бесплатной и платной функциональностью и разными ценами.

Определите свои задачи и выберите подходящий парсер. Используйте чек-лист для выбору парсера в зависимости от ваших требований:

| Парсер | Описание |

|---|---|

| XPath | Парсит данные с любого сайта по заданным XPath-выражениям |

| Sleuth | Парсит структуру сайта и позволяет извлекать нужные данные |

| Frog | Парсит мета-теги, описание сайта, изображения и другие данные |

| PR-CY | Парсит данные с большого числа сайтов с различной функциональностью и ценами |

В зависимости от вашего сайта или задачи выберите парсер, который наилучшим образом подходит для вашего случая. Он поможет вам быстро и эффективно собирать нужную информацию с веб-страницы.

Советы по использованию парсеров

Для успешного использования парсеров данных, важно учесть несколько рекомендаций:

- Если вы хотите получить данные с определенного сайта, сначала изучите его структуру. Определите, какие элементы вы хотите спарсить, какие значения вам нужны.

- Выберите подходящий парсер, учитывая свои задачи. Существует многое количество парсеров для web-скрапинга, доступно как браузерные расширения, так и самостоятельные программы для Windows.

- Необходимо делать выбор вариантов парсинга в зависимости от конкретной задачи. Если вам нужно спарсить много ссылок, то лучше использовать парсер, который может работать с большим объемом данных.

- Оцените функционал парсера. Некоторые парсеры могут предоставить расширенную функциональность, например, экспорт данных в Excel или мониторинг изменений на сайтах.

- Используйте xpath-запросы для анализа структуры HTML-элементов и получения нужной информации. Они позволяют парсить значения из мета-тегов, заголовков, описания страницы и других элементов сайта.

- Проверяйте правильность парсинга данных. Часто возникают ситуации, когда парсер не справляется с задачей или получает некорректные результаты. В этом случае стоит пересмотреть xpath-запросы или выбрать другой парсер.

- В случае парсинга информации о товарах или покупках, обратите внимание на функции парсера, способные спарсить цены, рейтинги, названия и другие характеристики товаров.

- Предварительно изучите особенности парсинга сайта, с которым вы собираетесь работать. Некоторые сайты могут иметь многое количество защитных механизмов, которые могут затруднить парсинг или запретить его.

- Применяйте парсеры данных в различных сферах. Они могут быть полезными для оптимизации контента, анализа позиций сайта или конкурентов, парсинга информации о товарах и многих других задач.

- Используйте удобный и функциональный парсер, который позволяет работать в облаке и предоставляет возможность сохранять данные в удобном формате.

Видео:

Импорт (парсинг) нетабличных данных с сайтов в Excel с помощью Power Query

Импорт (парсинг) нетабличных данных с сайтов в Excel с помощью Power Query by Nikolay Pavlov 105,240 views 2 years ago 14 minutes, 24 seconds